Exo AI 在家构建分布式 AI 超级集群

你的家,你的AI超级集群:释放Exo AI的强大功能!

I. 引言:AI的未来就在你的客厅

想象一下,无需数据中心或超级计算机,即可运行大规模AI模型。如果你的日常设备——手机、笔记本电脑,甚至是智能手表——能够协同工作,共同构建一个强大的AI大脑,那会是怎样一番景象?这并非科幻小说,而是Exo AI的承诺。

隆重介绍exo,这是exo labs推出的突破性开源项目,让你在家即可构建自己的分布式AI集群。告别昂贵的云服务或单台高性能计算机。Exo AI整合了你所有设备的强大功能,让你能够运行更大规模的AI模型,并以前所未有的速度获得结果,真正实现本地AI推理的普及化。

II. Exo 的神奇之处:内幕揭秘

Exo AI 集群的入门非常简单。Exo 会自动查找并连接所有运行该软件的设备。实际上,它就像即插即用一样简单,能将您的消费电子产品变成一个专属的 AI 超级集群。

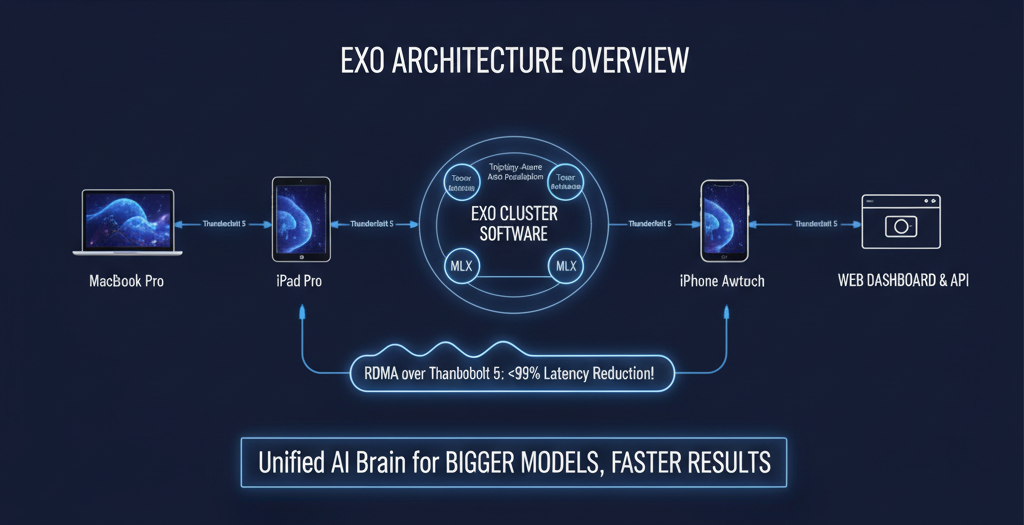

惊人的速度:Thunderbolt 5 上的 RDMA

速度不仅快,而且快得令人眼花缭乱。Exo AI 利用最新的 Thunderbolt 5 技术,通过 RDMA(远程直接内存访问)将设备间的通信延迟降低高达 99%!您可以将其视为一条专用的 AI 数据高速公路,对于高效的分布式 AI 操作至关重要。

Exo 是一个智能“宝贝”:基于拓扑的自动并行化

您的 Exo AI 集群并非只是一堆设备的简单堆砌。Exo 会智能地映射硬件,了解每个设备的计算能力和网络性能。然后,它会策略性地划分和分布 AI 模型,以实现最高效率和最佳的 本地 AI 推理。

分脑实现超高速:张量并行化

告别瓶颈!Exo AI 使用 张量并行化 将模型组件分布在各个设备上,从而显著提升复杂 AI 模型 的运行速度(在 2 个设备上速度提升 1.8 倍,在 4 个设备上速度提升 3.2 倍!)。

Apple Silicon 的最佳搭档:MLX 支持

Exo AI 基于 Apple 优化的 MLX 框架 (https://ml-explore.github.io/mlx/build/html/index.html) 构建,确保您的 Mac 以最佳状态运行,充分发挥 Apple Silicon 的全部潜能,实现 AI 推理。

您的控制中心:Web 控制面板和 API

通过用户友好的 Web 控制面板或简单的 API,监控您的 Exo AI 集群并与之交互。监控您的 家庭 AI 实验室 从未如此轻松。

III. 优势、劣势及详情:Exo 的优缺点

您爱上 Exo 的理由(优点):

-

人人皆可拥有 AI! Exo 利用您已有的硬件,让强大的 AI 惠及大众,使本地 AI 推理触手可及。

-

小空间,大模型! 运行通常单个消费级设备无法容纳的 AI 模型,将您的家变成一个超级 AI 集群。

-

极速性能! 得益于 Thunderbolt 5 的 RDMA 技术,您的 Exo AI 集群运行速度极快,实现了分布式 AI 前所未有的速度。

-

设置简单,无需操心! 简易的设置和智能自动化功能意味着更少的操作,更大的推理潜力。

-

领先优势: Thunderbolt 5 和 Apple Silicon 上的 MLX 的早期应用,使 Exo AI 跻身本地 AI 创新的前沿。(感谢 Jeff Geerling 在 Mac Studio 集群上对这些大型模型进行的性能基准测试!)

缺点:

-

当前 Mac 平台性能瓶颈: 目前,**最佳*性能(RDMA)仅限于配备 Thunderbolt 5 的 Mac,这限制了 Exo AI 性能的早期广泛应用。

-

Linux 用户:请耐心等待: 目前,Exo AI 仅支持 Linux 平台的 CPU。 GPU 加速功能正在开发中,但尚未推出,这意味着 Linux 上的分布式 AI 性能优化程度较低。

-

macOS 特有问题:可能有点挑剔? macOS 应用程序可能需要系统权限才能修改网络设置,以优化 RDMA 和 Exo AI 的性能。

-

尚处于早期阶段! 尽管 Exo AI 开发速度很快,但它仍然是一个相对较新的项目,因此预计其稳定性和文档方面会持续改进。请查看 Exo GitHub 代码库 获取最新更新和 贡献指南。

IV.入门指南:熟悉 Exo AI

最简便方法:macOS 应用程序

从 Exo 官方发布页面 (https://github.com/exo-explore/exo/releases) 下载 DMG 文件,拖放即可完成!(需要 macOS Tahoe 26.2 或更高版本)。这是部署 Exo AI 的最快方法。

DIY 用户:从源代码运行(macOS 和 Linux)

前提条件: Homebrew(Mac)、uv、node、rust(nightly 工具包)。Linux 用户需要通过 apt 下载 nodejs 和 npm。有关设置详情,请参阅 Exo 文档 (https://github.com/exo-explore/exo/blob/main/docs/getting-started.md)。

快速安装和运行(Mac/Linux):

git clone https://github.com/exo-explore/exo

cd exo/dashboard && npm install && npm run build && cd ..

uv run exo

Linux 用户请注意: 目前仅支持 CPU!请关注 Exo GitHub 获取 GPU 支持更新。

解锁超高速:在 macOS 上启用 RDMA(仅限 Thunderbolt 5 Mac)

快速进入恢复模式,然后运行简单的 rdma_ctl enable 命令即可加速您的 Mac,通过 Thunderbolt 5 接口实现 Exo AI 的最大性能。

您的首次 AI 对话:使用 Exo API

步骤 1:预览模型位置: 查看您的模型在 Exo AI 集群上的最佳运行位置。

curl "http://localhost:52415/instance/previews?model_id=llama-3.2-1b"

步骤 2:创建模型实例: 在您的 Exo AI 集群上启动您选择的模型。

curl -X POST http://localhost:52415/instance -H 'Content-Type: application/json' -d "..." # 使用预览输出

步骤 3:发送对话完成响应: 与您的 家庭 AI 实验室 聊天!

curl -N -X POST http://localhost:52415/v1/chat/completions \

-H 'Content-Type: application/json' \

-d '{ "model": "mlx-community/Llama-3.2-1B-Instruct-4bit", "messages": [...] }'

**步骤 4:清理:**完成后,请移除该实例,以释放 Exo AI 设置中的资源。

V. 技术社区对 Exo 的评价

Exo AI 在 GitHub 上拥有超过 38,000 个 star,显然正在吸引技术社区的关注,这表明人们对分布式人工智能和本地人工智能推理有着浓厚的兴趣。这是一个由 exo labs 积极开发的项目,并得到了活跃的贡献者社区的支持。Exo AI 项目欢迎贡献;请查看他们的 CONTRIBUTING.md 文件。

来自 Jeff Geerling 等权威专家的性能基准测试证实,Exo AI 能够显著提升 Mac Studio 集群上大型AI 模型的性能,尤其是在利用 Thunderbolt 5 和 Apple Silicon 时。

总而言之,Exo AI 对于任何对本地 AI 推理感兴趣的人来说,都是一个前景广阔、面向未来的解决方案,尤其适合那些拥有先进Apple Silicon硬件的用户。虽然 Linux 上的 GPU 支持�仍需进一步研究,但围绕这个分布式 AI项目的兴奋之情是毋庸置疑的!